内容

トップ

エッジコンピューティング

エッジAIと機械学習

機械学習のトレーニング手法

組み込みML

MLソフトウェア

TensorFlow

TensorFlow Lite

PyTorchとExecuTorch

エッジAIとMLハードウェア

要件

NPU

TPU

Edge Impulse

AIによるセンシング

機械学習を使用したビジョンセンサ

機械学習を使用したモーションセンサ

エッジAI

エッジコンピューティングでは、その名の通り、データソースの近くでコンピューティングを行います。これは、データの発生源から遠く離れたデータセンターでコンピューティング(計算処理)が行われるクラウドコンピューティングとは対照的です。たとえば、AlexaやSiriなどのスマートホームアシスタントにはエッジAIが搭載されています。「アレクサ」と声をかけると、エッジAIがそのフレーズを認識し、スマートホームアシスタントを起動します。

エッジコンピューティング

コンピューティングサービスに対するニーズが日々高まる中、大規模な集中型データセンターからエッジへの移行は意外に思われるかもしれません。しかし、データの発生源に近い場所でコンピューティングを行うことで、たとえば、プライバシーに関する懸念を軽減できます。かつてネットワークエッジは周辺機器や末端機器の領域でしたが、今日では高度な処理能力を持つものとなっています。

多くのリアルタイムアクティビティが、エッジコンピューティングの必要性を高めています。これらのアプリケーションは、すでにあなたの身の回りで使われているかもしれません。

- スマートホームアシスタント(Alexa、Google、Siriなど)は、エッジコンピューティングの一例として、「ウェイクワード」検出を使用しています。この場合、デバイスが素早く反応し、かつ、ユーザーのプライバシーも守る必要があるため、エッジコンピューティングが必要となります。

- 先進運転支援システム(ADAS)は、車線から逸脱した場合にドライバーに通知する機能などに重点を置いているため、クラウドとの往復処理の時間を待つことができません。また、ネットワークの応答が遅れるリスクを冒すこともできません。

- 患者モニタリング(血糖値モニタなど)は、患者の近くで動作します。 データを患者のスマートフォン(またはローカルデバイス)に送信するだけでよいので、保護された医療データがインターネットに晒される危険性を低減できます。

- 予知保全モデルは、産業用モータの振動量から異常を検知し、モータが焼損する前にアラートを発信します。 異常が検知されるとアラートがクラウドに送信されるかもしれませんが、それ以外の時間はエッジでデータを分析し、ネットワークの混雑を緩和します。

エッジコンピューティングとクラウドコンピューティングの違いとは何でしょうか? 解答を見る

クラウドコンピューティングは、データセンター(通常、データが生成される場所が、データが処理される場所から遠く離れています)で処理を行う一連のサービスを指します。 クラウドコンピューティングにおける計算動作の負荷(ワークロード)は、中央演算処理装置(CPU)またはグラフィック処理装置(GPU)を実行するサーバ上で処理されます。

エッジコンピューティングは、生成されるデータの近くで処理を行うサービスを指します。 エッジコンピューティングの計算負荷は、マイクロコントローラやシングルボードコンピュータ(SBC)で処理されることが多いです。

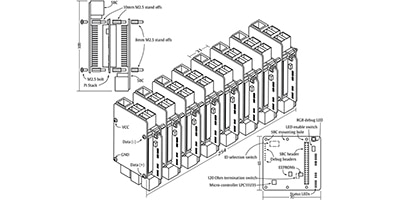

シングルボードコンピュータを使用したIIoTエッジコンピューティングプラットフォームの製作

シングルボードコンピュータ(SBC)を使うとエッジで強力な処理性能を発揮させることができますが、設計者は最善のソリューションを選択して適用する方法を知っておく必要があります。

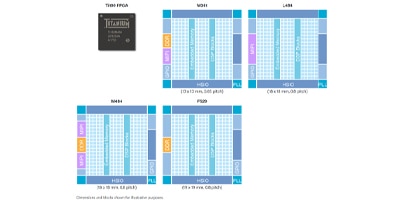

EfinixのQuantum対応FPGAの活用による、低電力かつ高性能のエッジコンピューティングの実装

EfinixのQuantum対応FPGAを利用することで、AI、ML、画像処理のエッジコンピューティング実装において消費電力、性能、面積の優位性を獲得できます。

エッジAIと機械学習

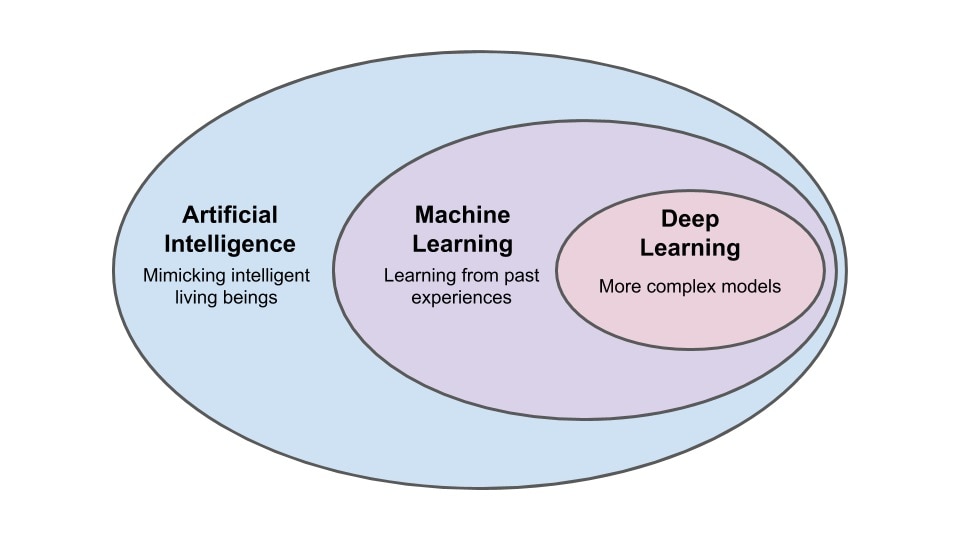

人工知能(AI)と機械学習(ML)は、最も広い定義では、直接的かつ明示的な指示が無くてもタスクのパフォーマンスを向上させるコンピュータアルゴリズムや統計モデルを使用することを意味します。 この能力により、開発者がすべての動作を定義する必要がなく、明示的に定義された従来のプログラミングとは異なり、自律的な改良と適応が可能になります。それは、自己改善とさらなる適応性を可能にし、インターネットコンテンツの推薦、音声認識、医療科学、自動運転車に至るまで、ほぼすべての分野で新たな用途を見出しています。

今日では、日常生活において益々多くのシステムが何らかのレベルでMLとのインタラクションを持つようになり、エンジニアや開発者がユーザーインタラクションの未来を理解するために、このAIやMLの世界を理解することが不可欠になっています。

人工知能(AI)は幅広い分野です。そして、特に機械学習(ML)はエッジで最も将来性がある分野です。MLは、統計アルゴリズムに基づいてパターンマッチングを行うプロセスです。

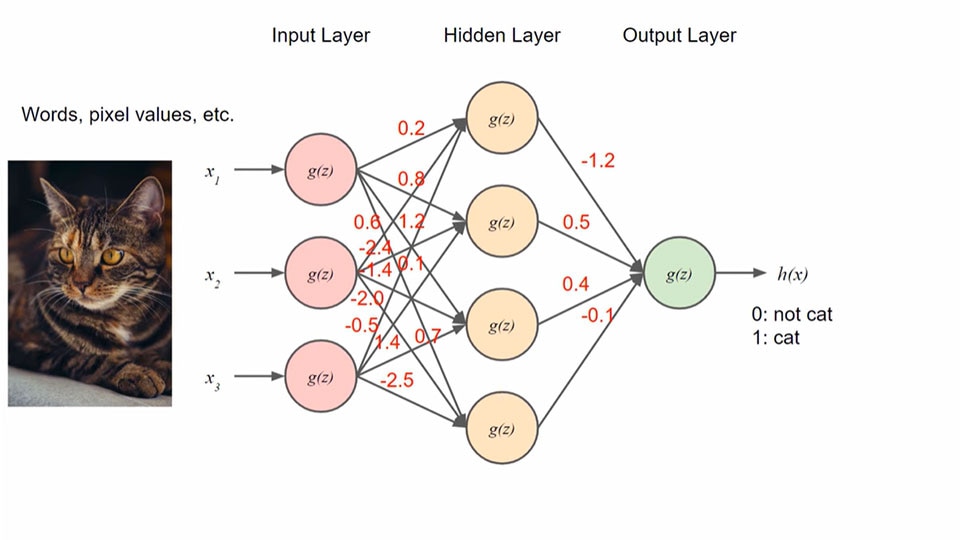

ニューラルネットワークの使用は、機械学習における一般的なトレーニング手法です。 以下の図は、このようなモデルにおけるノードと重み付けを示しています。

ディープラーニングは、ニューラルネットワーク内に複数の隠れ層を持つ、特殊なタイプの機械学習です。

機械学習モデルとは何でしょうか? 解答を見る

機械学習(ML)モデルとは、トレーニングデータの中で見つかったパターンに基づいて、入力データを認識し、分類するように設定されたソフトウェアプログラムのことです。トレーニングデータを使用することで、MLモデルはデータで見つかったパターンを抽出し、そのパターンを用いて将来の結果を予測し、より精度の高いモデルへと改良することができます。

機械学習のトレーニング手法

正しく機能するMLモデルを得るためには、トレーニングが必要です。モデルのトレーニングに使用できる学習方法には、いくつかの種類があります。

- 教師あり - ラベルやタグが付けられたサンプルデータに基づいたトレーニングの一種で、出力は既知の値であり、その正確性をチェックできます。これは、作業を進める中でその作業を修正してくれる家庭教師がいるようなものです。 このタイプのトレーニングは一般的に、分類作業やデータ回帰などの用途に使用されます。教師ありトレーニングは非常に有用で高精度ですが、タグ付けされたデータセットに大きく依存しており、新たな入力に対応できない可能性があります。

- 教師なし - 定義された出力を持つラベル付けトレーニングデータの代わりに、教師なし学習では学習アルゴリズムを用いて、ラベル付けされていないデータセットからデータクラスタを調査、分析、発見します。 一般的には、教師なし学習は、大規模データセットを調査し、データポイント間の関係を見つける必要があるアプリケーションで使用されます。

- 半教師あり - 教師ありトレーニングと教師なしトレーニングの両方を組み合わせたものです。トレーニングのデータセットには、タグ付きデータとラベルなしデータの両方が含まれます。半教師ありトレーニングは、他の手法よりも広範囲の入力データを扱えますが、教師ありや教師なしトレーニングよりも複雑になる可能性があり、ラベル付けされていないデータの質が最終モデルの精度に影響を与える可能性があります。

- 人間のフィードバックによる強化学習(RLHF)- 明確に定義可能なアクション、評価や改善が可能なパフォーマンス指標や結果を用いてトレーニングを行います。ルールセットと実行可能なアクションを定義することで、強化トレーニングは、目標条件を達成するために様々なアクションパターンの評価を継続して反復できます。

組み込みML

組み込みMLは機械学習のサブセットで、以下の条件のモデルの実行に焦点を当てています。

- 低レイテンシ: サーバ応答を待ったり、サーバに到達するまでのネットワーク遅延に対処したりしません

- 狭帯域幅: ネットワーク経由で高精細データを返しません

- 低電力: W単位ではなくmW単位です

組み込みMLモデルは、大規模なデータ処理ハードウェア(サーバやパーソナルコンピュータなど)に依存する代わりに、小型で低消費電力のデバイス(マイクロコントローラ、FPGA、DSPなど)に展開することができます。

組み込みMLアプリケーション向けモデルのトレーニングは、サーバやコンピュータ上で行われます。このプロセスでは、すべてのデータが入力され、結果として1つのモデルが生成されます。

一度生成された組み込みMLモデルは、組み込みシステム上で実行されます。組み込みMLの一般的なアプリケーションには、ウェイクワードの認識と起動、人や物体の識別、センサからのデータストリームに基づく異常検知などがあります。

エッジAI(または組み込みML)のメリットは何でしょうか? 解答を見る

- 低遅延: リモートサーバやネットワークの遅延を待つ必要がありません

- 狭いデータ帯域幅: ネットワーク経由で大量の高精細データを送受信する必要がありません

- プライバシー: センサの出力に前置フィルタをかけると共に、エッジデバイスで意思決定を行なうことで、データをインターネット経由で送信する必要がなくなります

- 低消費電力: 組み込みMLの消費電力はW単位ではなくmW単位のため、バッテリ駆動のモバイルデバイスに最適です

- 小さなデータフットプリント: 組み込みMLは、数十KBのフラッシュメモリに収まるように設計されています

- 経済的で低コストのデバイス: 組み込みMLは32ビットMCU上でローカルに演算処理ができ、システム全体のコストは50ドル以下になることが多いです

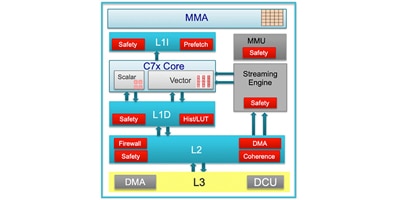

TI Edge AI - ディープラーニングアクセラレータを搭載した AM6xA プロセッサとその効率性

ディープラーニングアクセラレータを搭載したTIプロセッサ TIのAM6xA(例えば AM68Ax および AM69Ax )エッジAIプロセッサは、ディープラーニング計算用の特別用途向けのアクセラレータを備えたヘテロジニアスアーキテクチャを採用しています。

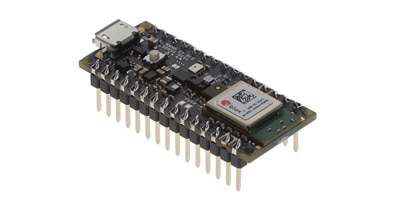

SAMD21機械学習(ML)評価キット

SAMD21機械学習(ML)評価キット EV18H79:TDKの6軸MEMS付きSAMD21機械学習(Machine Learning、ML)評価キット ATSAMD21

機械学習を駆使したホームシーン:インテリジェントなホームオートメーションのための青写真

機械学習により、スマートホームデバイスを新しいシームレスな方法で操作できるようにするスマートホームシーンが実現されます。

エッジ対応の機械学習アプリケーションの迅速な展開方法

NXPのi.MX RT1170クロスオーバーMCUと関連ボードおよびソフトウェアツールにより、エッジにおける機械学習の実装が大幅に簡素化されます。

IMU: オンボードの機械学習によりホストのスリープ状態を維持可能

機械学習と決定木処理をIMUに統合することにより、リアルタイムの位置および動きの処理をホストアプリケーションプロセッサからオフロードできます。

ワークロードの統合とセキュリティによってAIとMLを最大限に活用

処理リソースをローカルで統合して、AIとMLの機能をエッジに展開することにはいくつかのデメリットがあります。主要なデメリットはセキュリティです。

MLソフトウェア

TensorFlow

TensorFlowは、機械学習モデルを構築、トレーニング、および展開するための無料のオープンソースソフトウェアライブラリです。 元々は2011年にGoogleがGoogle Brainプロジェクト向けに開発したもので、2015年にアップデート版が一般公開され、2019年に現行版TensorFlow 2.0がリリースされました。

TensorFlowは、機械学習のトレーニングとディープニューラルネットワークの推論のために、最も人気があり広く使用されているフレームワークです。多くの開発者がPython APIライブラリを介してTensorFlowとやりとりしていますが、TensorFlowはJava、JavaScript、およびC++プログラミング言語に対応しています。サードパーティのパッケージではオプションが増えていて、MATLAB、R、Haskell、Rustなど、ほぼすべての言語が利用可能になります。

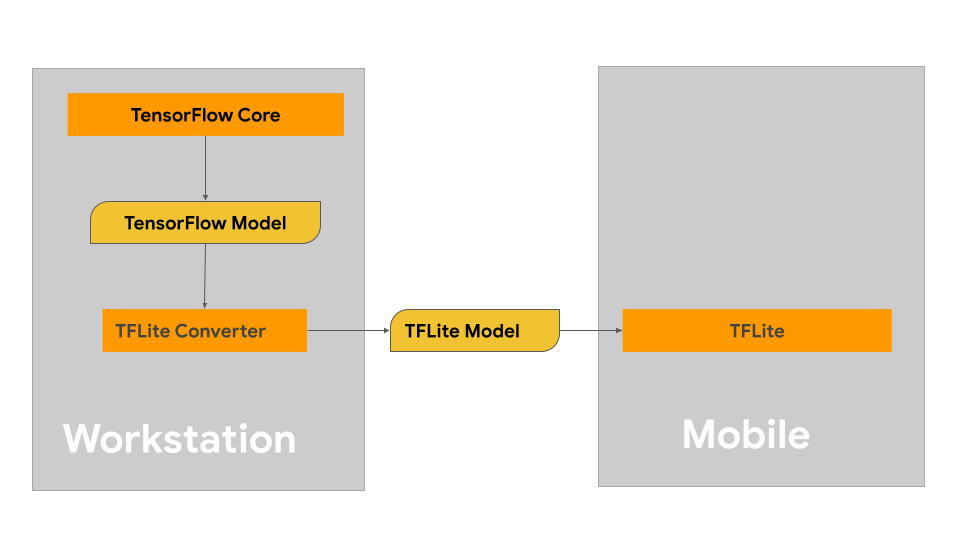

TensorFlow Lite

TensorFlowLiteは、小規模作業向けに設計されたTensorFlowのサブセットです。組み込みシステム、モバイルデバイス、エッジコンピューティングデバイスなど、ハードウェアの制約や電力に制限のあるデバイスなどが対象となります。開発者は、TensorFlowで既存のMLモデルをトレーニング、作成、または修正し、TensorFlowLiteを使用してより小さく効率的なソフトウェアパッケージに変換することで、モバイルデバイス上で実行できるようにすることができます。

しかし、一旦マイクロコントローラプラットフォームに展開されると、ローカルで実行するには過大な演算パワーと時間が必要になるため、通常はデバイス上でMLモデルを更にトレーニングすることはありません。つまり、モデルは通常、新たなデータソース無しに完全にオフラインでトレーニングされます。この限定的なアプローチは、単一のタスクを実行するアプリケーションに最適です。ただし、広範囲のデータを分類する必要があります。

TensorFlowとTensorFlow Liteの違いは何でしょうか? 解答を見る

TensorFlowは、完全な汎用オペレーティングシステム(GPOS)と共に、より規模が大きいコンピューティングハードウェアを必要とします。

TensorFlowLiteは、組み込みシステム、モバイルデバイス、あるいはエッジコンピューティングデバイス上でMLモデルを実行するために最適化されています。

GPOSをサポートするRaspberryPi4のようなシングルボードコンピュータ(SBC)は、適切なサイズのSBC上でフルのTensorFlowを実行可能ですが、通常消費電力はMCUやDSPよりもはるかに大きく、10~20ワットとなることが多いので注意してください。

一般的に、モデルのトレーニングはTensorFlow上で実行されます。軽量の組み込みシステム上で動作するモデルはTensorFlow Lite上で動作するように変換されます。

PyTorchとExecuTorch

ローカライズされたハードウェアプラットフォーム上でMLモデルを実行するニーズの高まりに応えるために、PyTorchはExecuTorchを開発しました。ExecuTorchは、スマートフォン機能を持ったウェアラブルデバイスや組み込みプラットフォーム上でMLモデルを実行するための完全なエンドツーエンドのソフトウェアツールです。 ExecuTorchは、モデリングから変換、展開まで、通常のPyTorchと同じツールチェーンとSDKを操作でき、また、幅広いCPU、NPU、DSPプラットフォームとも互換性があります。

ExecuTorchはPyTorch 2.0で構築されているため、ユーザーフレンドリーであり、スマートフォンアプリケーション向けのAndroidサポートを含む幅広いデバイスでサポートされています。

PyTorch Edge、ExecuTorch、PyTorch Mobileの違いは何でしょうか? 解答を見る

PyTorch Edgeは、エッジでMLモデルを実行することをコンセプトとしています。 PyTorch Mobileはこれを実現したレガシーのツールセットであり、ExecuTorchはエッジでPyTorchモデルを実行するための最新のツールセットです。

PyTorch Mobileは、特にiOS、Android、LinuxベースのモバイルデバイスにPyTorchを移行するための初期の試みでしたが、アプリケーション開始時に静的なメモリのフットプリントを必要とするという制限がありました。一方、ExecuTorchは動的なメモリを持ち、必要なときに、必要なだけのメモリを割り当てます。これはメモリに制約のある環境では重要な機能です。

TensorFlowモデルをPyTorch上(またはその逆)で実行できますか? 解答を見る

TensorFlowとPyTorchは似たようなソフトウェア環境ですが、現在のところ直接の相互互換性はありません。 それぞれのシステムが使用するトレーニン グ手法やモデルファイルの出力が異なるため、あるエコシステムから別のエコシステムへとモデルを移行するのは難しいのです。

ただ幸運なことに、この2つを簡単に変換できる別の選択肢があります。 オープンソースのMLソフトウェアシステムONNX(Open Neural Network Exchange )は、MLのエコシステム間でトレーニングモデルのファイルを変換するツールを備えています。

ONNXがMLエコシステムの仲介的な役割を果たすことで、開発者は多くの異なるMLのトレーニング手法に取り組み、様々な手法でモデルを最適化することができます。

Syntiant TinyMLを使用するためのソフトウェアについて

Syntiant TinyML(Tiny Machine Learning)開発ボードは、低消費電力の音声、音響イベント検出(AED)、センサMLアプリケーションを構築するためのプラットフォームです。

エッジ対応の機械学習アプリケーションの迅速な展開方法

NXPのi.MX RT1170クロスオーバーMCUと関連ボードおよびソフトウェアツールにより、エッジにおける機械学習の実装が大幅に簡素化されます。

機械学習の初心者にとっても専門家にとっても大いに魅力があるSTM32のエコシステム

エッジでの機械学習を加速させるためのツールやプラットフォームは数多くあります。STM32のエコシステムには、初心者と専門家を両方とも惹き付ける多くの魅力があります。

エッジAIとMLハードウェア

TensorFlow Lite for Microcontrollersは、マイクロコントローラ規模のアプリケーション向けに設計されたMLソフトウェアプラットフォームです。オペレーティングシステム、CやC++ライブラリ、または動的なメモリアプリケーションを必要としないため、TensorFlow Lite for Microcontrollersは小型ながらも、標準的なプログラミングオプションよりも非常に強力です。

なぜマイクロコントローラでエッジAIを行うのでしょうか? 解答を見る

マイクロコントローラは小型で柔軟性があり、低消費電力、低コストのオプションで、世界中の数十億のデバイスで使用されています。マイクロコントローラは完全なコンピュータシステムが必要ない場合に有利です。ローカルで意思決定を行ったり、受信したデータを処理したりできるマイクロコントローラの能力が、MLの分野で特に関心を集めています。データをローカルで処理する追加のメリットとして、エンドユーザーのプライバシーが保護されることがあげられます。たとえば、ドアベルのビデオデータをクラウドにアップロードしなくても、誰かが玄関ドアに近づいているかどうかを知りたい場合があるでしょう。

要件

TensorFlow Lite for Microcontrollersは、C++17プログラミング言語で開発されており、動作させるには32ビットマイクロコントローラプラットフォームが必要です。

TensorFlow Lite for Microcontrollersのソフトウェアコア操作は、16KBのメモリしかないARM Cortex Mプラットフォーム上でも実行可能で、よく使われているEPS32プラットフォームにも移植されています。また、適切なArduinoプラットフォームで動作させたい場合は、TensorFlow Lite for Microcontrollersフレームワーク用のArduinoソフトウェアライブラリさえもあります。

TensorFlow Lite for Microcontrollersにはどのような制約があるでしょうか? 解答を見る

TensorFlow Lite for Microcontrollersは、最小規模のハードウェア要件で動作する強力な機械学習プラットフォームですが、次のような制約があり、開発が困難になる場合もあります。

- 公式にサポートされているデバイスが少ないです。通常は、高性能の32ビットプラットフォームが必要になります。

- TensorFlowLiteと同様、マイクロコントローラ上でのトレーニングがサポートされていません。

- 基本的なTensorFlow操作のごく一部のサブセットしか、サポートされていません。

- メモリ管理には、低レベルのC++アプリケーションプログラミングインターフェース(API)が必要となる場合があります。

その他の組み込みシステム

組み込みLinuxを実行できる高性能のハードウェアシステムやRaspberry PiプラットフォームのようなSBCにMLモデルを展開した場合、TensorFlow Liteプラットフォームも同様に実行できます。

ハードウェアアクセラレータ

チップレベルでは、機械学習やニューラルネットワークの計算をサポートするために、特定のプロセッサにより多くの専用演算ロジックが追加されています。

NPU

ニューラルプロセッシングユニット(NPU)は、ニューラルネットワークに基づく機械学習や人工知能アプリケーションの処理を高速化するために設計された特殊なICです。

ニューラルネットワークは、人間の脳に基づいた構造となっており、情報を処理して伝達するニューロンと呼ばれる多数の層とノードが相互に接続されています。

TPU

テンソルプロセッシングユニット(TPU)は、Googleが2015年に開発した専用ICで、ニューラルネットワークベースのシステムの処理を支援するよう設計されていますが、NPUとは異なり、ニューロンベースのシステムアーキテクチャを使用せず、行列の乗算や畳み込み演算の高速な処理を実行することでこれを行っています。

TPUは、低エネルギーで数学的な行列演算を処理するよう高度に最適化されているため、TensorFlowやExecuTorchのような演算を使用したMLモデルのトレーニングに最適です。

第1世代のTPUハードウェアは、電源と冷却の要件があるため、通常はデータセンターアプリケーションでしか見られません。 しかし、最新世代のTPUは、エッジベースのアプリケーション向けに設計されています。

エッジAIでは、どうしてCPUやGPUがあまり使われていないのでしょうか? 解答を見る

従来の中央演算処理装置(CPU)は、汎用の演算処理には優れているものの、ニューラルネットワークのあらゆる演算を効率的に処理するようには最適化されていません。 グラフィック処理装置(GPU)もまた、機械学習や人工知能アプリケーションに非常に有用ですが、エネルギー使用量や必要なハードウェアのオーバーヘッドが大きいため、エッジでの利用は限られています。

エントリーレベルの製品

Arduino® Nano 33 BLE Sense Rev2

NINA-B306、nRF52840 Arduino Nano 33BLE Sense Rev2(ヘッダ付き) - ARM® Cortex®-M4F MCU 32ビット 評価ボード - 組み込み

ミドルレベルの製品

XIAO ESP32-S3 Senes

- OV2640 トランシーバ;802.11 b/g/n (Wi-Fi、WiFi、WLAN)、Bluetooth® 5.x 2.4GHz 評価ボード

アドバンスレベルの製品

エキスパートレベルの製品

その他の製品

Raspberry Pi、PyPortal Titano、およびmachinechatのJEDI OneによるIoT MQTTブローカのセットアップとテスト

概要 このプロジェクトでは、machinechatのIoTデータ管理ソフトウェアJEDI Oneを使って、Raspberry Pi 4にIoT MQTTブローカをセットアップします。

AI/ML画像処理にEfinix FPGAを使用する理由と方法 - 第1部:導入

Efinix FPGAと関連する開発ボードを使用することで、設計者はAI/ML画像処理アプリケーションを迅速に開発・デプロイできます。

ワークロードの統合とセキュリティによってAIとMLを最大限に活用

処理リソースをローカルで統合して、AIとMLの機能をエッジに展開することにはいくつかのデメリットがあります。主要なデメリットはセキュリティです。

FPGAを使用して、高性能で電力効率の高いエッジAIアプリケーションを素早く構築します。

専用IPとソフトウェアにより、FPGAの経験がない開発者でもFPGAベースのエッジAIを迅速に展開することができます。

Design GatewayのIPコアを使ってXilinx VCK190評価キット上でAIアプリケーションを高速化

計算効率の高いASICクラスのAI計算エンジンと柔軟なプログラマブルファブリックを組み合わせて使うことで、AI推論の難題を解決できます。

Edge Impulse

Edge Impulseはクラウドベースの統合開発環境(IDE)であり、これにより、ソフトウェア開発者は実世界のデータを収集、インポートしてMLモデルを構築、トレーニング、テストすることで、エッジコンピューティングのデバイスでMLモデルを効率的に実行できます。

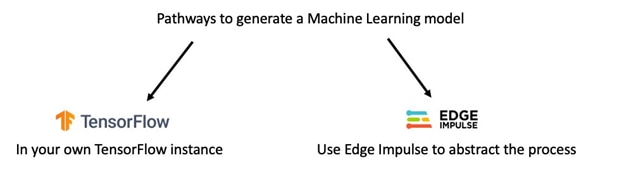

機械学習ソフトウェアのEdge ImpulseとTensorFlowの違い - Edge Impulseではモデル開発のプロセスが簡略化されユーザーの関わりが薄いですが、TensorFlowではユーザーが開発プロセスにより深く関わっています。

機械学習ソフトウェアのEdge ImpulseとTensorFlowの違い - Edge Impulseではモデル開発のプロセスが簡略化されユーザーの関わりが薄いですが、TensorFlowではユーザーが開発プロセスにより深く関わっています。

Edge Impulseの得意分野

Edge Impulseフレームワークは、マイクの音声、カメラの画像、振動センサのデータなど、あらゆるデータを処理できます。 その他の例としては、以下のようなものが挙げられます。

- 物体認識と画像検出: 人物検出など

- 音声検知: スマートホームアシスタントにおける「ウェイクワード」検知など

- 異常検知: 予防保守用

- アクティビティ/パターン認識: プロセスの合理化のため

Edge Impulseを使うべき理由は何でしょうか? 解答を見る

Edge Impulseを使用することで、MLトレーニングソフトウェア(現時点では、主にTensorFlow)で行う必要がある作業負荷を軽減することができます。 Edge Impulseは、データをタグ付けしてアップロードしてモデルをトレーニングできるウェブベースのインターフェースを提供します。

Edge Impulseは、MLトレーニングソフトウェアを使用したことのない初めてのユーザーや非ML開発者を対象に設計されていますが、TensorFlowPythonフレームワークと互換性があるため、エキスパートレベルのユーザーにも思いのままに使っていただくことが可能です。エッジAIモデルを作成する際に必要となるコーディングの障壁の多くを取り除くことで、適切なモデルをトレーニングすることに集中でき、コードを実行するためにどのPythonライブラリを含めるべきかなどというようなことをあまり気にする必要がなくなります。

ほとんどの開発者やユーザーには無料利用枠がありますが、無料利用枠ではプロジェクトの数や各プロジェクトで使用できる処理能力に制限があります。 プロフェッショナルの開発者向けには有料枠が用意されており、Edge Impulseに連絡して料金を交渉できます。

![]()

NordicのThingy:53 IoTプロトタイピングプラットフォーム

![]()

Nordic SemiconductorのNordicThingy:53は、統合されたモーション、サウンド、光、および環境センサを活用して、概念実証とプロトタイプの構築を支援します。

Edge Impulseと互換性のあるボードの一覧は、こちらをご覧ください。

https://docs.edgeimpulse.com/docs/edge-ai-targets/fully-supported-development-boards

AIによるセンシング

機械学習モデルの実行には組み込みシステムが必要ですが、AI対応の電子部品として市場に出される製品は今後も増え続けるでしょう。 これには、MLセンサとも呼ばれるAI対応センサが含まれます。

機械学習センサができること

ほとんどのセンサに機械学習モデルを追加しても、アプリケーションでの効率は上がりませんが、MLトレーニングによって処理が大幅に効率化できるいくつかのタイプのセンサが存在します。

- フレーム内の物体や人物を追跡するための機械学習モデルを内蔵したカメラセンサ

- アクティビティプロファイルを検出するためのIMUセンサ、加速度センサ、モーションセンサ

機械学習を使用したビジョンセンサ

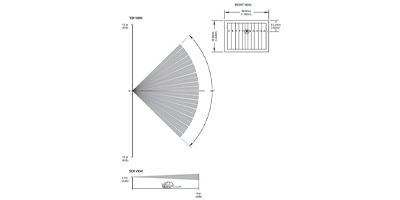

ニューラルネットワークを使用して計算アルゴリズムを提供することで、カメラセンサの視野内に移動する物体や人を検出、追跡することが可能になります。

Renesas RZ/V2シリーズ MPUによる視覚認識システム設計の加速化

Renesas RX/V2 MPUを使用することで、設計者はDRP-AIハードウェアアクセラレータを使用した視覚認識システムを大幅に高速化できます。

AIビジョンセンサ

機械学習を使用したモーションセンサ

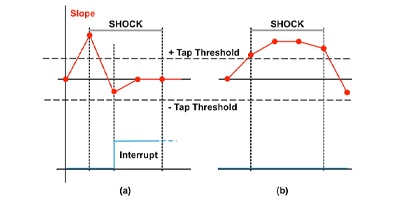

機械学習プラットフォームが統合されたモーションセンサでは、センサと同じパッケージ内でリアルタイムにデータを追跡・処理することができ、消費電力と処理時間を低減できます。このタイプのセンサのほとんどは、小さな計算論理ベースの意思決定ツリーを持つか、フィルタやトリガの閾値を事前定義する機能をもつことができます。入力値がこのレベルに達したときに、この行動を実行するといった感じです。他のモーションセンサには、パッケージに完全なDSPユニットを内蔵しており、複数のMLアルゴリズムをプライマリCPUなしで実行できるため、電力と時間を節約できるものもあります。

スマートセンサに内蔵される機械学習コアを使用して「常時オン」モーショントラッキングを最適化

機械学習コアを統合したスマートセンサを使用して、複雑な動きのシーケンスを低電力の常時オンによるモーショントラッキングで検出します。

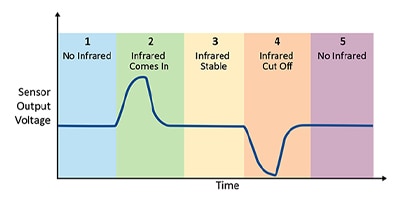

ZilogのZmotion検知製品

ZilogのZMOTION検知/制御ならびに侵入検知製品ファミリは、PIR(受動赤外)ベースのモーション検知アプリケーション向けに、統合されたフレキシブルなソリューションを提供します。

ATtiny1627 Curiosity Nanoを使ったモーション検出の効率化

Microchip ATtiny1627 Curiosity NanoセンサとPIRセンサを使用すれば、モーション検出の手順を素早く学習して使用し始めることができます。

長期的に製品提供される高機能かつ長寿命のIMUを採用することで、産業用デバイスの長い製品寿命を確保

堅牢な産業用IMUは、その長期的な製品提供が約束されることで、産業用デバイスにますます求められる堅牢な性能、安定性、および長寿命の要件を満たします。

出典:

出典: 出典:

出典:

出典:

出典: 出典:

出典: 出典:

出典: 出典:

出典: 出典:

出典: