SLAM:ロボットが未知の地形をナビゲートする方法

見知らぬ砂漠に取り残され、安全な道を探すという困難な任務に直面することを想像してくさい。不慣れな地形でのナビゲーションは、人間にとってもロボットにとっても長年の課題でした。従来のロボットや自律走行車両のナビゲーション手法では、既存の地図を必要としますが、未開の地では、そのような地図を入手することは、その地域を横断しなければ不可能です。これはロボティクスにおける古典的なジレンマであり、しばしば「鶏と卵」の問題として引用されます。ロボットは地図なしで未知の環境をどのようにナビゲートできるのでしょうか。そして、最初に環境をナビゲートすることなく、どのようにして地図を作成できるのでしょうか。

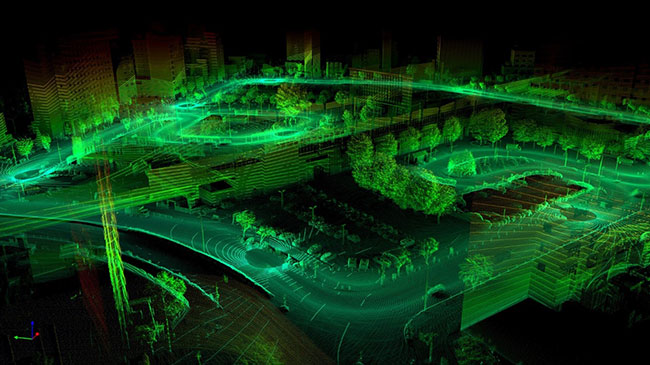

3DビジュアルSLAMマップまたはビジュアルSLAMを使用して作成したSLAMマップ。(図は www.flyability.comより転載、画像提供:Sigmoidal.ai)

3DビジュアルSLAMマップまたはビジュアルSLAMを使用して作成したSLAMマップ。(図は www.flyability.comより転載、画像提供:Sigmoidal.ai)

そこで、SLAM(Simultaneous Localization and Mapping)という概念が登場します。Hugh Durrant-Whyte氏やJohn J. Leonard氏などの研究者によって開発されたSLAMは、ロボットが未知の環境を自律的にナビゲートし、リアルタイムでマッピングすることを可能にする技術です。SLAMは、既存の地図に依存するのではなく、ロボットが周囲の地図を作成すると同時に、その地図の中で自分の位置を特定することが可能です。SLAMの核心は、マッピングとローカリゼーションという2つの主要なプロセスにあります。マッピングとは、環境の空間表現を作成することであり、ローカリゼーションとは、そのマップ内でロボットの位置を特定することです。これらのプロセスは絡み合っており、ロボットはセンサデータに基づいてマップを継続的に更新し、それに応じて位置の推定を調整します。

SLAMの実施にはいくつかの重要なステップがあり、それぞれがプロセス全体において重要な役割を果たします。これらのステップには、ランドマーク抽出、データ関連付け、状態推定、更新が含まれます。ランドマーク抽出では、マッピングとローカリゼーションの基準点として使用できる、環境内の明確な特徴やランドマークを識別します。データの関連付けでは、センサの測定値をマップの特徴と照合し、状態の推定では、センサのデータに基づいてロボットの位置と姿勢を推定します。最後に、更新では新しいセンサの測定値に基づいて地図と位置の推定値を修正します。

SLAMの有効性を決定する重要な要素のひとつは、使用するセンサの種類です。センサによって精度や情報量が異なるため、得られる地図やローカリゼーションの推定値の品質に影響を与える可能性があります。たとえば、ビジュアルSLAM(vSLAM)はカメラを主要なセンサとして利用し、ロボットが周囲から視覚情報を抽出することが可能です。この視覚情報には、エッジ、コーナー、テクスチャなどの特徴が含まれ、マッピングやローカリゼーションのランドマークとして使用できます。さらに、カメラは、物体の検出や認識などのタスクに役立つ豊富な意味情報を提供します。一方、LiDARベースのSLAMはLiDARセンサ(SparkFunのSLAMTEC SEN-15870など)を利用し、レーザービームを照射して環境内の物体までの距離を測定します。LiDARセンサは高精度で正確なため、複雑な形状を持つ環境のマッピングに適しています。しかし、LiDARセンサは高価で計算量が多いため、特定のシナリオでは適用が制限されることがあります。

vSLAMには、使用するカメラの種類に応じていくつかのサブカテゴリがあります。単眼SLAM、ステレオSLAM、RGB-D SLAMなどがあります。単眼SLAMは、1台のカメラを使ってロボットの動きと環境の構造を推定します。ステレオSLAMは、互いに既知のベースライン距離に配置された2台のカメラで構成されるステレオカメラのセットアップを利用します。このセットアップにより、視覚的特徴の三角測量が可能になり、奥行きの推定とマッピングの精度が向上しました。最後に、RGB-D SLAMは、従来のRGBカメラと、MicrosoftのKinectやIntel RealSenseカメラなどの深度センサを組み合わせたものです。この深度情報の追加により、より正確な3Dマッピングとローカリゼーションが可能になります。

vSLAMの各サブカテゴリには、コスト、計算の複雑さ、環境条件などの要因に応じて、独自の利点と制限があります。たとば単眼SLAMは、そのシンプルさと低コストのために広く使われています。しかし、環境の規模を直接推定することができないため、規模の曖昧さに悩まされます。ステレオSLAMは、奥行きと規模を推定するために視覚的特徴の三角測量を利用することで、この問題に対処できます。一方、RGB-D SLAMは、RGB画像と深度情報の組み合わせのおかげで、最高レベルの精度と詳細な情報を提供します。

ロボティクスへの応用に加え、SLAMはさまざまな産業で、数多くの現実世界のアプリケーションに使用されています。ロボティクスでは、SLAMによってロボットが倉庫や工場、災害地などの動的環境を自律的にナビゲートし、探索することが可能になります。自律走行車両では、SLAMは道路の高精細マップを作成し、そのマップ内で車両の位置を特定するために使用されます。SLAMはまた、拡張現実(AR)や仮想現実(VR)にも応用されており、現実世界の環境に仮想オブジェクトを重ね合わせることで、没入感のある体験を作り出すために使用されています。

SLAMには多くの利点がありますが、欠点もあります。SLAMの主な課題の1つは、センサデータの処理とマップのリアルタイム更新に伴う計算の複雑さです。これは、大量のデータが必要な環境や計算リソースが限られた環境では、特に難しくなる可能性があります。さらに、SLAMは、環境中の明確な特徴やランドマークが利用できるかどうかに大きく左右されます。一様な地形や特徴のない地形の環境では、SLAMは正確な地図を作成したり、ロボットの位置を効果的に特定するのに苦労するかもしれません。

結論として、SLAM(Simultaneous Localization and Mapping)は、ロボットが自律的にナビゲートし、未知の環境をリアルタイムでマッピングすることを可能にする強力な技術です。マッピングとローカリゼーションを1つのプロセスに統合することで、SLAMは予備知識や既存の地図がなくてもロボットが周囲を探索し、理解することを可能にします。SLAMには独自の課題と限界がありますが、そのアプリケーションはロボティクス、自律走行車両、AR、VRなどの業界にまたがり、広大で多様です。技術の進歩に伴い、SLAMはロボティクスとオートメーションの未来を形作る上でますます重要な役割を果たしています。

リファレンス:

- SLAMについて(Simultaneous Localisation And Mapping)(vercator.com)

- SLAM(Simultaneous Localization and Mapping)入門|Ouster

- 30分でゼロからのSLAM:対話型ワークショップ|Ouster

- SLAM(Simultaneous Localisation and Mapping)とは - MATLAB & Simulink - MATLAB & Simulink (mathworks.com)

- SLAMの定義と進化 - ScienceDirect

- SLAMで使用される主要アルゴリズムの紹介 - 技術記事 (control.com)

- ローカリゼーション - ロボティクスと知覚入門 (roboticsbook.org)

Have questions or comments? Continue the conversation on TechForum, Digi-Key's online community and technical resource.

Visit TechForum